Børns sikkerhed har altid været en kritisk bekymring i teknologiindustrien, især når det kommer til at forhindre cirkulation af materiale til seksuelt misbrug af børn (CSAM). Apples forsøg på at løse dette problem gennem on-device og iCloud CSAM-detektionsværktøjer tog en kontroversiel drejning, da det først blev annonceret.

Apples beslutning om at opgive CSAM-detektionsværktøjer i december 2022 har rejst spørgsmål, og en børnesikkerhedsgruppe kaldet Heat Initiative har været i spidsen for at presse Apple for at få svar. Som svar har teknologigiganten givet sin mest detaljerede forklaring til dato for opgivelsen af sine CSAM-detektionsplaner.

Apple afviste CSAM-detektion for børns sikkerhed og brugernes privatliv

Materiale til seksuelt misbrug af børn er fortsat et dybt bekymrende problem, som kræver proaktive løsninger. Apple introducerede oprindeligt konceptet med CSAM-detektionsværktøjer i et forsøg på at bekæmpe spredningen af dette skadelige indhold. Imidlertid stod virksomheden over for betydelige tilbageslag og etiske bekymringer om brugernes privatliv og sikkerhed. I kølvandet på denne kontrovers tog Heat Initiative en stærk holdning mod Apples beslutning og truede med at organisere en kampagne imod den.

Mere læsning:Apple dræber CSAM Detection for iCloud-billeder for at koncentrere sig om kommunikationssikkerhed for meddelelser

I et omfattende svar på Heat Initiative (viaKABLET), Erik Neuenschwander, Apples direktør for brugerbeskyttelse og børns sikkerhed, understregede, at beslutningen om at opgive CSAM-detektion ikke blev taget let på. Han skitserede virksomhedens engagement i forbrugersikkerhed og privatliv som drivkraften bag omdrejningspunktet mod et funktionssæt kendt som kommunikationssikkerhed. Neuenschwander forklarede, at forsøg på at få adgang til krypteret information til CSAM-detektion ville være i konflikt med Apples bredere privatlivs- og sikkerhedsprincipper, som har været i modstrid med forskellige regeringskrav.

Apples svar understregede dets urokkelige holdning mod at kompromittere brugernes privatliv og sikkerhed. Neuenschwander påpegede, at udbredt scanning af privat lagrede iCloud-data ville introducere nye sårbarheder for potentielle databrud. Desuden ville det skabe en farlig præcedens, der kunne føre til masseovervågning og utilsigtede konsekvenser, hvilket udhuler de grundlæggende principper, som Apple er rost for.

Neuenschwanders svar henvendte sig direkte til Sarah Gardner, lederen af Heat Initiative, som havde udtrykt skuffelse over Apples beslutning om at opgive CSAM-detektion. Gardner mente, at den foreslåede løsning ville have positioneret Apple som førende inden for brugernes privatliv og samtidig udrydde en betydelig mængde CSAM fra iCloud. I sit budskab formidlede hun, at det haster med at implementere kritisk teknologi til at bekæmpe seksuelt misbrug af børn.

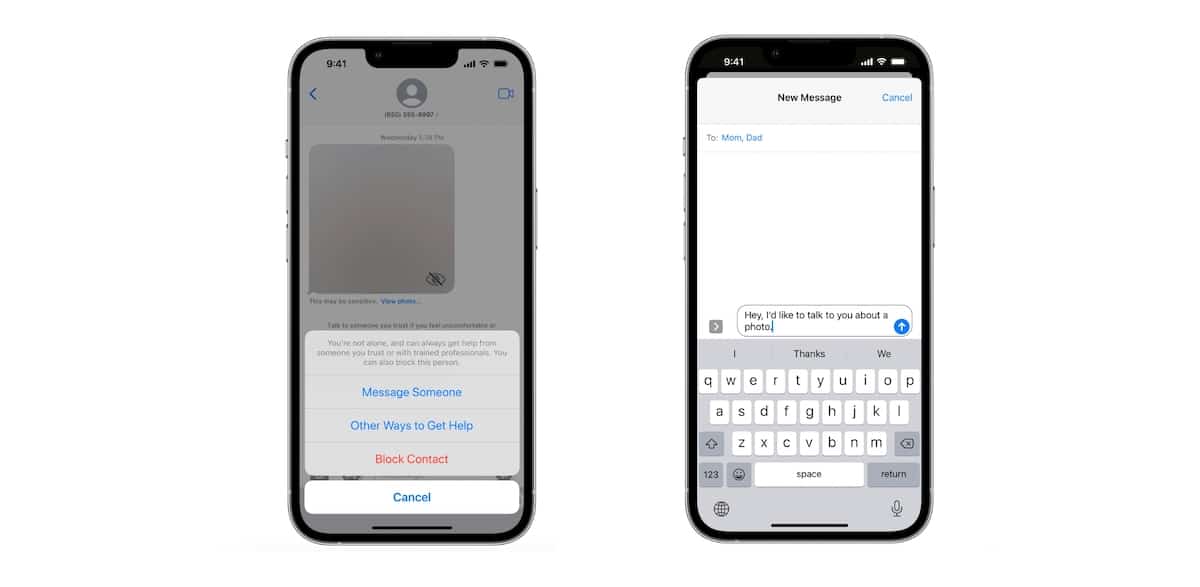

Apples tilgang, snarere end at fungere som mellemmand til behandling af rapporter, fokuserer på at vejlede ofre mod passende ressourcer og retshåndhævende myndigheder. Virksomheden udvikler API'er, som tredjepartsapps kan bruge til at uddanne brugere og lette rapportering af lovovertrædere. Apple har også introduceret funktionen Kommunikationssikkerhed, som hjælper brugere med at filtrere eksplicit indhold fra deres beskeder. Selvom denne funktion oprindeligt var tilgængelig for børns konti, er den indstillet til at udvide til voksne i iOS 17 med planer om yderligere udvidelse i fremtiden.

Det er vigtigt at bemærke, at Apples beslutning om ikke at fortsætte med CSAM-detektion var drevet af virksomhedens ubøjelige forpligtelse til brugernes privatliv og sikkerhed. Svaret på Heat-initiativet tydeliggør de bekymringer og overvejelser, der førte til denne afgørende beslutning. Selvom det stadig er et afgørende problem at håndtere seksuelt misbrug af børn, sigter Apples tilgang på at finde en balance mellem at beskytte brugerdata og hjælpe med at bekæmpe CSAM.