Apple afslørede for nylig en række nye funktioner designet til at gøre deres produkter mere tilgængelige og brugervenlige. Fra Eye Tracking til Music Haptics imødekommer disse opdateringer en bred vifte af brugerbehov.

Lad os se nærmere på nogle af de spændende nye funktioner, der snart kommer til iPhones, iPads og andre Apple-enheder.

"Hvert år bryder vi ny vej, når det kommer til tilgængelighed,"sagdeSarah Herrlinger, Apples seniordirektør for Global Accessibility Policy and Initiatives. "Disse nye funktioner vil gøre en indvirkning på livet for en bred vifte af brugere og give nye måder at kommunikere, styre deres enheder og bevæge sig gennem verden på."

Øjensporing

Den mest fremtrædende nye funktion er Eye Tracking, som giver brugerne mulighed for at navigere på deres iPhones og iPads ved kun at bruge deres øjenbevægelser. Drevet af kunstig intelligens og ved at udnytte det frontvendte kamera, giver Eye Tracking brugere mulighed for at udføre bevægelser som at trykke og stryge, alt sammen med øjnene. Med tilføjelsen af Dwell Control kan brugere nemt vælge elementer på skærmen med et enkelt blik.

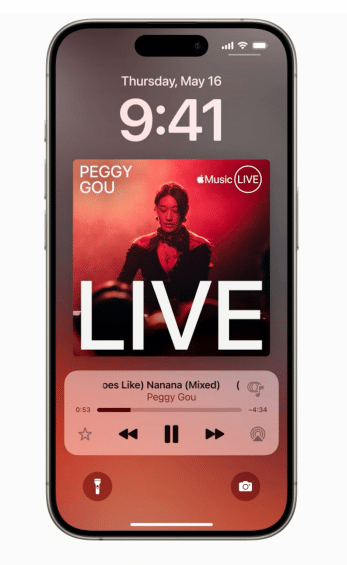

Musik Haptics

For brugere, der er døve eller hørehæmmede, introducerer Apple Music Haptics, en funktion, der bruger Taptic Engine til at oversætte musik til en række tryk, teksturer og vibrationer. Denne innovative tilgang giver brugerne mulighed for at opleve rytmen og følelserne i deres yndlingssange på en helt ny måde. Music Haptics vil være tilgængelig på tværs af millioner af numre i Apple Music-kataloget og vil også være tilgængelige for udviklere gennem en ny API.

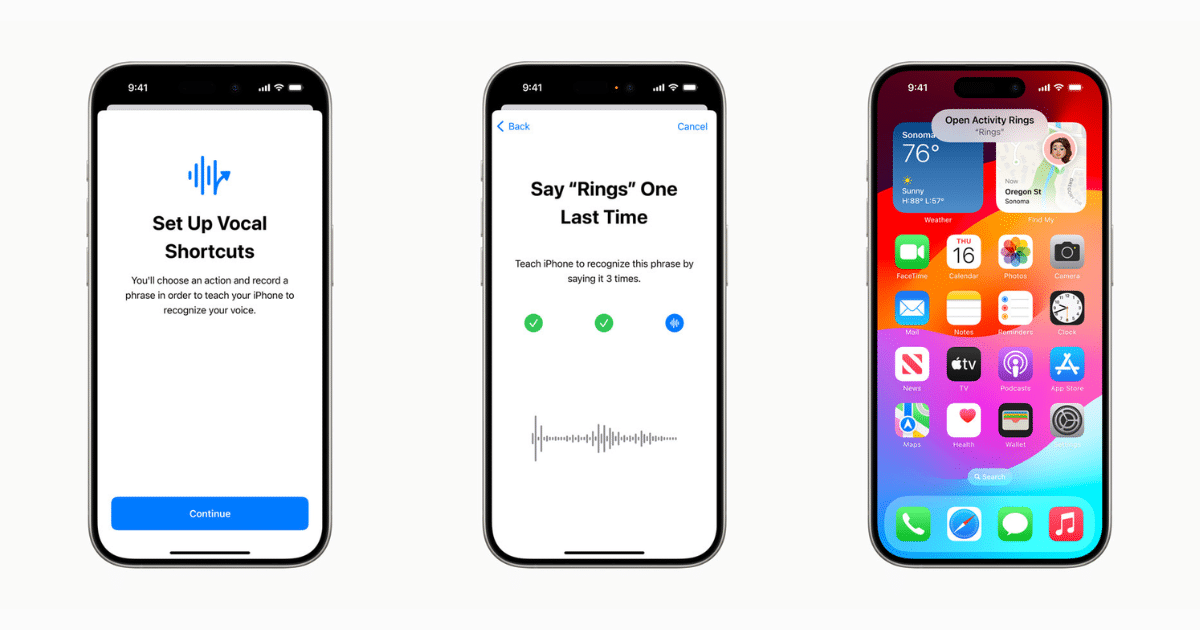

Vokalgenveje og lyt efter atypisk tale

Vokalgenveje giver brugerne mulighed for at tildele brugerdefinerede ytringer til Siri, så de kan starte genveje og udføre opgaver med enkle stemmekommandoer. Derudover bruger Listen for Atypical Speech maskinlæring til at genkende unikke talemønstre, hvilket gavner brugere med tilstande, der påvirker tale, såsom cerebral parese, ALS eller slagtilfælde.

Lyt efter atypisk tale bruger maskinlæring på enheden til at genkende brugernes talemønstre. Designet til brugere med erhvervede eller progressive tilstande, der påvirker tale, såsom cerebral parese, amyotrofisk lateral sklerose (ALS) eller slagtilfælde, giver disse funktioner et nyt niveau af tilpasning og kontrol, der bygger på funktioner introduceret i iOS 17 for brugere, der ikke taler eller risikerer at miste deres evne til at tale.

Køretøjets bevægelsessignaler

For at imødegå køresyge, mens du bruger en iPhone eller iPad i et køretøj i bevægelse, introducerer Apple Vehicle Motion Cues. Denne funktion viser animerede prikker på skærmens kanter, der repræsenterer ændringer i køretøjets bevægelser og hjælper med at reducere sansekonflikter uden at forstyrre hovedindholdet. Ved at bruge sensorer indbygget i enheden genkender Vehicle Motion Cues automatisk, når brugeren er i et køretøj i bevægelse og justerer derefter.

Foreslået læsning:Sådan aktiverer/deaktiverer du øjensporing fra iPhone-låseskærm i iOS 18

CarPlay tilgængelighedsopdateringer

Apples in-car software, CarPlay, modtager også tilgængelighedsopdateringer, herunder stemmestyring, farvefiltre og lydgenkendelse. Stemmestyring giver brugerne mulighed for at navigere i CarPlay og interagere med apps ved kun at bruge deres stemme, mens lydgenkendelse giver brugere, der er døve eller hørehæmmede, besked om vigtige lyde som bilhorn og sirener.

Live billedtekster til visionOS

visionOS 2 introducerer Live Captions, der gør det muligt for brugere, der er døve eller hørehæmmede, at følge med i talt dialog i livesamtaler og i lyd fra apps. Denne opdatering forbedrer yderligere tilgængeligheden af Apples økosystem for brugere med synsnedsættelse.

Yderligere tilgængelighedsforbedringer

Ud over de førnævnte funktioner introducerer Apple en række andre tilgængelighedsforbedringer, herunder opdateringer til VoiceOver, Magnifier, Braille Screen Input, Hover Typing, Personal Voice, Live Speech og Virtual Trackpad. Disse opdateringer er designet til at forbedre brugervenligheden for brugere med forskellige handicap og sikre, at Apple-produkter er tilgængelige for alle.

Med disse nye tilgængelighedsfunktioner fortsætter Apple med at føre an i at skabe teknologi, der er inkluderende og brugervenlig.

"Apple Vision Pro er uden tvivl den mest tilgængelige teknologi, jeg nogensinde har brugt," sagde Ryan Hudson-Peralta, en Detroit-baseret produktdesigner, tilgængelighedskonsulent og medstifter af Equal Accessibility LLC. "Som en, der er født uden hænder og ude af stand til at gå, ved jeg, at verden ikke er designet med mig i tankerne, så det har været utroligt at se, at visionOS bare fungerer. Det er et vidnesbyrd om styrken og vigtigheden af tilgængeligt og inkluderende design."

WWDC 2024

Hold øje med den officielle afsløring af disse funktioner ved Apples kommende WWDC-begivenhed den 10. juni, hvor softwareopdateringerne vil blive frigivet senere i år.